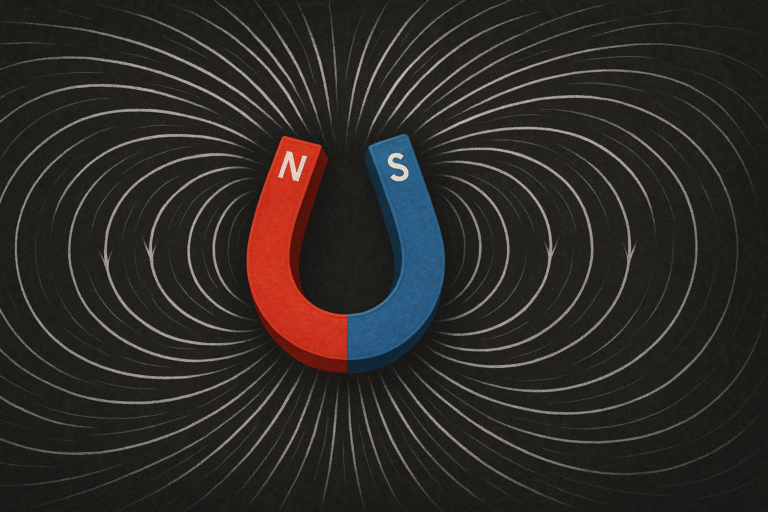

Nya forskningsresultat visar att stora språkmodeller (LLM) bearbetar olika typer av data på ett sätt som liknar den mänskliga hjärnan6. Precis som hjärnan har ett ”semantiskt nav” som integrerar information från olika modaliteter, använder LLM en liknande mekanism för att bearbeta olika typer av data på ett centralt och generaliserat sätt6.

Huvudsakliga fynd

Semantiskt nav: LLM omvandlar indata från olika modaliteter till modalitetsoberoende representationer i sina interna lager, vilket liknar hur hjärnans semantiska nav integrerar diverse information6.

Dominerande språk: En engelskdominerad modell ”tänker” på engelska när den bearbetar indata på andra språk eller i andra format, som datorkod eller matematiska problem64.

Liknande representationer: Modellen tilldelar liknande representationer till indata med liknande betydelser, oavsett datatyp (text, bild, ljud, kod)6.

Forskningsmetoder

Forskarna genomförde experiment där de:

- Matade in meningspar med samma betydelse på olika språk och mätte likheten i modellens representationer6.

- Undersökte hur en engelskdominerad modell bearbetade text på andra språk och jämförde representationerna med engelska6.

- Utförde liknande experiment med andra datatyper som kod och matematiska problem6.

Implikationer

Dessa fynd kan hjälpa forskare att träna framtida LLM som är bättre på att hantera olika typer av data6. Det kan potentiellt användas för att uppmuntra LLM att dela så mycket information som möjligt mellan olika datatyper samtidigt som de behåller förmågan att generera korrekta utgångar för varje specifik modalitet7.

Denna forskning ger värdefulla insikter i hur LLM bearbetar och resonerar kring olika typer av data, vilket kan leda till förbättringar inom områden som flerspråkig förståelse, multimodal inlärning och generell artificiell intelligens.

Citations:

- https://www.uu.nl/en/news/data-diversity-as-the-foundation-for-better-language-models

- https://research.google/pubs/exploring-length-generalization-in-large-language-models/

- https://www.digitalocean.com/community/tutorials/understanding-reasoning-in-llms

- https://www.labmanager.com/large-language-models-reason-about-diverse-data-like-humans-do-33583

- https://arxiv.org/abs/2502.03671

- https://news.mit.edu/2025/large-language-models-reason-about-diverse-data-general-way-0219

- https://quantumzeitgeist.com/unveiling-the-brain-like-reasoning-mechanisms-of-large-language-models-a-new-approach-to-processing-diverse-data/

- https://newsletter.maartengrootendorst.com/p/a-visual-guide-to-reasoning-llms

- https://ground.news/article/like-human-brains-large-language-models-reason-about-diverse-data-in-a-general-way

- https://www.interconnects.ai/p/why-reasoning-models-will-generalize

- https://arxiv.org/abs/2501.09686

- https://multilingual.com/new-research-from-welo-data-establishes-a-multilingual-framework-for-evaluating-causal-reasoning-in-large-language-models/

- https://openreview.net/forum?id=jpSLXoRKnH

- https://openreview.net/forum?id=dCPF1wlqj8

- https://en.wikipedia.org/wiki/Large_language_model

- https://arxiv.org/html/2411.07681v1

- https://arxiv.org/html/2311.09799v3

- https://news.mit.edu/2024/reasoning-skills-large-language-models-often-overestimated-0711

- https://www.linkedin.com/posts/mit-csail_like-human-brains-large-language-models-activity-7297980804817702913-jBsw

- https://www.youtube.com/watch?v=eULIf02frIw